Screaming Frog SEO Spider Download

zahlung

Herunterladen

Rückblick Screaming Frog SEO Spider

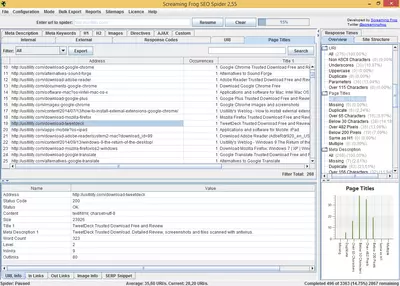

Screaming Frog SEO Spider ist ein Tool, das uns hilft, einige der wichtigsten SEO-Faktoren von Websites zu analysieren.

Die Erstellung einer Website ist oft eine Aufgabe, an der mehrere Personen mit unterschiedlichen Aufgaben beteiligt sind. Selbst bei maximaler Aufmerksamkeit für alle Details kann es einige Fehler im Design oder in der Struktur der Website geben. Um diese Fehler zu entdecken, ist es wünschenswert, ein Tool zu haben, das alle Webseiten unserer Website überwacht und nach Fehlern oder Problemen sucht.

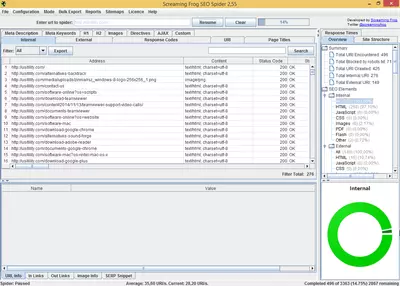

Screaming Frog SEO Spider ist ein ideales Tool, um Website-Probleme zu analysieren und zu melden. Das Programm ist einfach zu bedienen; wir müssen nur einige Grundeinstellungen vornehmen und die URL der Website eingeben, die wir analysieren wollen. Nach einer Minute oder Stunden, je nach Größe und Tiefe der Website, erhalten wir einen Bericht mit nützlichen Informationen, die wir filtern und neu anordnen können, um mögliche Ausfälle oder Fehler auf der Website zu finden.

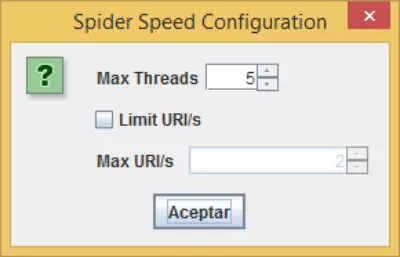

Als Erstes müssen wir den "Spider" einstellen (so heißt das Programm, das die Webseiten, aus denen die Website besteht, besucht und Informationen sammelt). Einige der Optionen, die wir einstellen können, sind die folgenden:

- Bilder, CSS, Javascript, SWF prüfen: Mit dieser Option kann das Programm Dateien, CSS, JS usw. auf den Webseiten prüfen und jeden gefundenen fehlerhaften Link melden.

- Externe Links prüfen: Wenn unsere Seite Links zu anderen Seiten hat, prüft diese Option, ob diese Links nicht defekt sind.

- Internen oder externen Links "nofollow" folgen: Mit dieser Option kann der Spider "nofollow"-Links folgen oder sie ignorieren. Diese Option ist sehr nützlich, wenn wir wissen wollen, wie viele "dofollow"-Seiten unsere Website insgesamt enthält.

- Subdomains crawlen: Wenn unsere Website mehrere Subdomains hat und wir sie "spinnen" wollen, müssen wir diese Option aktivieren.

- robots.txt-Datei ignorieren: Wenn wir bestimmte Bereiche unserer Website mit Hilfe der Datei robots.txt gesperrt haben. Wenn wir möchten, dass unser Spider diese Datei ignoriert und alle Bereiche der Website untersucht, müssen wir diese Option aktivieren.

- Die Gesamtzahl der zu crawlenden Seiten begrenzen: Mit dieser Option begrenzen wir die Anzahl der Seiten, die der "spider" crawlt.

- Tiefensuche begrenzen: Mit dieser Option können wir den Spider so einstellen, dass er nur ein paar Klicks von der Startseite entfernt crawlt.

- Authentifizierung anfordern: Wenn eine der Webseiten, die Teil der Website sind, passwortgeschützt ist, fordert uns das Programm mit dieser Option auf, einen Benutzernamen und ein Passwort einzugeben, um auf die geschützte Seite zuzugreifen und sie zu analysieren.

- Noindex respektieren: Wenn wir diese Option markieren, wird der Spider die Seiten mit dem Meta-Tag "Noindex" nicht crawlen. Es ist ratsam, diese Option zu verwenden, wenn wir die Gesamtzahl der in Suchmaschinen wie Google indexierten Seiten wissen wollen.

- Kanonisch respektieren: Wenn wir diese Option aktivieren, wird der Spider die Seiten nicht crawlen, die das Metatag rel="canonical" enthalten.

Aktivieren wir die Optionen Respect noindex und Respect Canonical, erhalten wir einen vollständigen Bericht über die Seiten, die von den Suchmaschinen indiziert werden, da sich unser Spider nach den Regeln der meisten Internetsuchmaschinen verhält. Vielleicht generiert unsere Website zehntausende von Seiten. Wenn wir jedoch die Metatags noindex und rel="canonical" korrekt einrichten, wird die Anzahl der indizierten Seiten erheblich reduziert, was dazu beiträgt, den internen PR der wichtigen Seiten zu erhöhen.

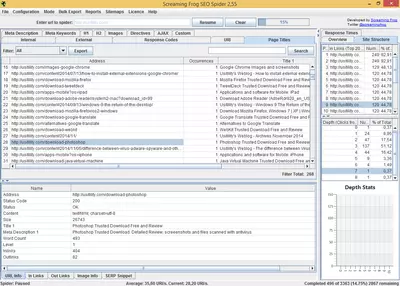

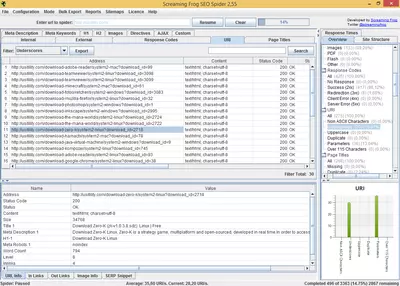

Sobald der Spider alle Webseiten gecrawlt hat, erstellt die Software eine Liste der überprüften Seiten. Diese Liste enthält die folgenden Informationen:

- URL: Adresse der untersuchten Webseite

- Statuscode: meldet den HTTP-Statuscode. Dadurch können wir sehen, welche Seiten nicht gefunden wurden (404) oder welche Serverfehler haben (500).

- Titel und Länge: zeigt den Titel der URL und die Anzahl der Zeichen an, die er enthält.

- Meta-Beschreibung und Länge: zeigt den Inhalt der Meta-Beschreibung und ihre Länge an.

- H1, H2, und Länge: Zeigt den Text der beiden Labels (falls vorhanden) und ihre Länge an.

- Größe: die Größe der Seite in Bytes. Es ist wichtig, die Größe der Webseite zu kennen, da eine zu große Größe zu einer langsamen Downloadgeschwindigkeit führt, und die Downloadgeschwindigkeit ist ein wichtiger Faktor für die Platzierung in Suchmaschinen.

- Die Anzahl der Wörter: Dieses Feld gibt die Anzahl der Wörter auf der analysierten Seite an. Dieser Faktor ist auch deshalb wichtig, weil Suchmaschinen Seiten, die nur wenige Wörter enthalten, als Seiten von schlechter Qualität einstufen.

- Ebene: Dies bezieht sich auf die Tiefenebene der analysierten Seite. Wenn eine Seite z. B. die Stufe 1 hat, bedeutet das, dass diese Seite nur einen Klick vom Index der Website entfernt ist. Diese Option wird verwendet, um zu prüfen, ob die Seiten, die wir für unsere Website für wichtig halten, eine niedrige Ebene haben, denn wenn sie eine hohe Ebene haben, interpretieren die Suchmaschinen, dass diese Seiten nicht so wichtig sind wie die niedrigeren Ebenen.

- Eingehende Links: Dieses Feld gibt die Anzahl der internen Seiten an, die auf die analysierte Seite verlinken. Diese Zahl ist wichtig, weil wir so wissen, welche Seiten am meisten verlinkt sind und überprüfen können, ob es sich dabei um die wichtigsten Seiten unserer Website handelt. Wenn nicht, können wir die interne Struktur unserer Website so ändern, dass die wichtigsten Seiten verlinkt werden.

- Ausgehende Links: Dies ist die Anzahl der Links zu anderen internen Seiten.

Das Programm besteht aus verschiedenen Registerkarten, die bestimmte Berichte enthalten. Auf der Registerkarte "Antwortcode" können wir zum Beispiel HTTP-Statuscodes (200, 404 usw.) sehen und nach Antwortcode filtern und organisieren. Jede Registerkarte enthält zusätzliche Informationen, die in der Hauptliste nicht angezeigt werden. Auf der Registerkarte "Antwortcode" können wir zum Beispiel die Antwortzeit der gecrawlten URLs sehen.

Screaming Frog SEO Spider kann eine Sitemap-Datei hochladen, so dass wir überprüfen können, ob die in dieser Datei enthaltenen URLs richtig funktionieren. Diese Option ist sehr praktisch, denn die URLs leiten die Suchmaschinen in der Sitemap dazu an, unsere Seite zu untersuchen. Die Sitemap darf also keine Fehler enthalten und die URLs müssen gültig sein.

Wir können die erzeugten Daten in .csv Dateien exportieren und sie in Excel oder eine andere Tabellenkalkulation importieren, um die Informationen in diesen Dateien zu bearbeiten.

Diese Software wurde in Java entwickelt und ist für alle wichtigen Desktop-Betriebssysteme verfügbar: Windows, Mac, und Linux.

Diese Software ist kostenpflichtig, kann aber für eine begrenzte Zeit mit bestimmten Funktionseinschränkungen genutzt werden, wie z.B. einer Begrenzung auf 500 URLs pro Website und der Unmöglichkeit, den Spider nach eigenem Geschmack zu konfigurieren.

von Rubén Hernández

Häufig gestellte Fragen

- Ist Screaming Frog SEO Spider für Windows 10 herunterladbar?

- Ja, diese Software kann heruntergeladen werden und ist kompatibel mit Windows 10.

- Mit welchen Betriebssystemen ist es kompatibel?

- Diese Software ist mit den folgenden 32-Bit-Windows-Betriebssystemen kompatibel:

Windows 11, Windows 10, Windows 8, Windows 7, Windows Vista, Windows XP.

Hier können Sie die 32-Bit-Version von Screaming Frog SEO Spider herunterladen. - Ist sie mit 64-Bit-Betriebssystemen kompatibel?

- Ja, obwohl es keine spezielle 64-Bit-Version gibt. Sie können also die 32-Bit-Version herunterladen und sie auf 64-Bit-Windows-Betriebssystemen ausführen.

- Welche Dateien muss ich herunterladen, um diese Software auf meinem Windows-PC zu installieren?

- Um Screaming Frog SEO Spider auf Ihrem PC zu installieren, müssen Sie die ScreamingFrogSEOSpider-18.2.exe Datei auf Ihr Windows-System herunterladen und installieren.

- Welche Version des Programms soll ich herunterladen?

- Die aktuelle Version, die wir anbieten, ist die 18.2.

- Ist Screaming Frog SEO Spider kostenlos?

- Nein, Sie müssen für die Nutzung dieses Programms bezahlen. Sie können jedoch die Demoversion herunterladen, um es auszuprobieren und zu sehen, ob es Ihnen gefällt.

- Home

- Screaming Frog SEO Spider home

- Kategorie

- Betriebssysteme

- Windows 11

- Windows 10

- Windows 8

- Windows 7

- Windows Vista

- Windows XP

- Lizenz

- Shareware